Register for free to receive our newsletter, and upgrade if you want to support our work.

Az évezred eddigi legnagyobb szoftveres felhajtását ünnepli talán a mesterséges intelligencia (artificial intelligence, AI), ami valószínűleg még a 2010-es évek blockchain őrületét is túlszárnyalja. A két hype azért is hasonló, mert mindkét technológia, bizonyos szempontból, fals ígéretekkel kecsegtet.

Blockchain hype után

A blockchain mániát a Bitcoin kriptovaluta elterjedése alapozta meg, amit Satoshi Nakamoto álnéven publikált egy anonim csoport 2008-ban (akinek Budapesten szobrot is állítottak). A blockchain ígérete, hogy “elosztott konszenzust” valósít meg, ami a számítástechnika egy régi és ismerten nehéz problémája, de amire a blockchain sem talált fundamentálisan új megoldásokat.[1] A probléma gyökere az ún. bizánci viselkedés, ami annyit jelent, hogy a blockchain-ben résztvevő szereplők tetszőleges(en kártékony) módon részt vehetnek a rendszerben. A Bitcoin megoldása erre az ún. bányászás (aka proof of work), amivel a szereplő bizonyítani tudja “érdemességét”, hogy kritikus műveleteket végezhessen a blockchain-ben. Azonban ez az alapprobléma csak egy sok esetben működő, de általánosan nem biztonságos megoldását kínálja, és morális/környezetvédelmi problémákat is fölvet, pl. hogy a bányászás sok áramot fogyaszt. A fenti problémák egy részére javasoltak megoldásokat (pl. a bányászatra vonatkozó alternatívákat), de a konszenzussal kapcsolatos fundamentális limitációkat a blockchain sem tudja átlépni.

Szerencsére a kriptó mellett a blockchain-nek léteznek kulturális (legalábbis kulturálisabb) felhasználásai is, mint a decentralized autonomous organization-ök (DAO), az NFT-k, vagy például koncert belépők újszerű kezelésére vonatkozó kezdeményezések. Egyelőre azonban úgy néz ki, hogy a Web 3.0 tag-gel is jelölt ambiciózus mozgalomnak több a füstje, mint a lángja.

Az AI csapda

Az AI-nak is számos fundamentális számítási kihívással kell megküzdenie, de talán egy fontos különbség, hogy az AI-nak több az “ártalmatlan” és mégis hasznos felhasználása. A fenti blockchain alkalmazás példákban senki se szeretné, hogy a limitált Grimes artwork NFT-jét vagy a Nick Cave koncert token-belépőjét ellopja valaki, a klasszikus kriptó (azaz, pénz) felhasználásról nem is beszélve (ahol “double spending”-gel szokás riogatni, ami azt jelenti, hogy valaki kontóján kétszer terhelik ugyanazt a tételt). Ezzel szemben ha a Suno mondjuk rossz zenét szerez vagy a ChatGPT nem tudja, mi az a Lahmacun radio, akkor arra lehet úgy tekinteni, hogy szubjektív és/vagy kontextus függő.

Egy, az AI-jal kapcsolatos fals ígéret az lehet, hogy intelligenciát ígér, ami még a konszenzusnál is fundamentálisabb koncepció, és amit nagyon nehéz (ha nem lehetetlen) formalizálni – ellenben a konszenzussal, ami a modern emberi társadalmak és technológiák egyik alap és sok esetben formalizált struktúrája (lsd. szavazások, cset alkalmazások stb.). A szimpatikus és hiteles az AI megközelítésben az, hogy tanulással éri el az intelligenciát, ami az emberi agyi fejlődésnek is az alapja. Az emberi agy analógiában van azonban egy erős csúsztatás, mégpedig az agyi működés matematikai leképzése, ami egy, ugyan látványos, a neuronok működését szimbolizáló egyszerű struktúrán alapul, de hogy ennek mennyi köze van a valósághoz, az kérdéses. A neuronok metafóra tehát inkább tekinthető jó brandingnek, ezzel együtt pedig egy alkalmas és hatékonynak tűnő matematikai absztrakciónak – ezzel kapcsolatban lásd pl. Andrew Ng véleményét, aki az AI kutatás egyik meghatározó szereplője.

Deep learning: az új sztár

Az előbb említett Andrew Ng idézetből az is kiderül, hogy az elmúlt évek AI robbanásának két fő motorja volt: az egyik, hogy az ún. mély (deep) neurális hálókról kiderült, hogy nagyon hatékonyan tudnak nem triviális és valós problémákat megoldani; a másik, hogy a grafikus kártyákkal (GPU) nem csak Bitcoint lehet jól (azaz gyorsan) bányászni, hanem neurális hálókat is tanítani.

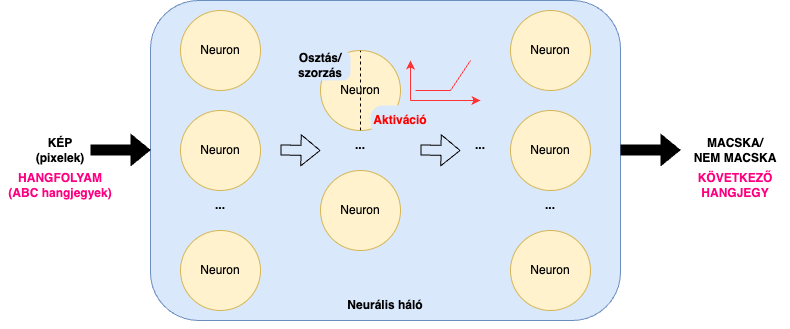

A modern AI alapjául szolgáló neurális háló egy nagyon egyszerű (matematikai értelemben gráf) struktúra, amit a következő ábra szemléltet.

Az AI-jal megoldandó problémát (pl. a klasszikus van-e macska a képen) számok formájában kell kifejezni (pl. pixelek színkódjainak sorozata). Ha a neurális hálóra mint “fekete dobozra” gondolunk, akkor az a bemenet (a kép) alapján kiszámolja az eredményt és mint kimenet visszaadja a választ (van-e a képen macska vagy sem). Ha belenézünk a dobozba, a neurális háló egyszerű számítási egységekből (az emberi agy analógia szerint neuronokból) áll, amik a bemenetről kapott számokkal (a kép pixeleivel) végeznek különböző, egyszerű műveleteket, és az eredményt továbbadják a szomszéd egységeknek. Az, hogy a hálót alkotó egységekre mint neuronokra gondolunk (és emiatt hívják a hálót neurális hálónak), az pont az a többé-kevésbé önkényes analógia, amiről fent szó volt. Egy további érdekesség, hogy ezek a “neuronok” egyszerű osztás és szorzás mellett még végezhetnek ún. aktivációkat is, amik matematikai értelemben szintén egyszerű, de már nem-lineáris függvények, és amik nélkül nem lehetne bizonyos, az életben természetesen előforduló problémákat leképezni – a fenti ábrán pl. egy ún. “relu” nevű aktivációs függvény látható.

A mély tanulás (deep learning) kifejezés a neurális háló méretére utal, amit nem csak a benne lévő neuronok száma határoz meg, hanem az is, hogy hány ún. rétegbe (layer) vannak rendezve a neuronok. Minden függőleges neuron oszlop egy réteg (a fenti ábrán pl. három réteg látszik), úgy hogy a neuronok csak a (jobbra) következő rétegnek tudnak közvetíteni számításokat (legalábbis az ún. feedforward hálókban). Az utolsó réteg kimenete pedig a problémára adott válasz (macska vagy nem macska).

Az elmúlt évtizedek legnagyobb (popularitású) informatikai innovációjának központjában tehát gyakorlatilag középiskolai matek áll. Ez még akkor is meglepő lehet, ha a hálók tanításához szükség van algebrára (mátrix aritmetika), differenciálszámításra, ill. a modern neurális háló alkalmazások erősen építenek valószínűségszámításra vagy játékelméletre.

Generatív AI

Felhasználóként, lassan két évvel az első ChatGPT verzió megjelenése után, majdnem mindenkinek van már közeli tapasztalata fejlett AI alkalmazásokkal. Ítélje meg mindenki, hogy ezeknek az alkalmazásoknak milyen a minősége (és veszélye emberi munkára), lsd. például ebben cikkben szereplő, újonnan promptolt “modulár szinti” galéria vagy az alább linkelt reggae album (shout out to Sub Burek, ahol nemrég szólt a “Step Natty” a lenti albumról). Egy vonatkozó anekdota, hogy amikor az UH interjún dolgoztam és említettem egy újságíró barátomnak, hogy AIrite-tal íratom le a felvételt (további szerkesztői-szerzői feldolgozás előtt), akkor egyértelművé tette, hogy nincs túl jó véleménnyel az (AIrite) eszközről. A cégnév tényleg rossz, de én úgy gondoltam, hogy abból a 3 órás szabadtéri szleng-motyogásból (az Orczy út felett-mellett a Gólya teraszán) azt a leiratot kihozni nem semmi – azt is figyelembe véve, hogy egy niche és magyar nyelvű kontextusban tette ezt. Tény, hogy a direkt kimenetet nem lehet publikálni, de én egyelőre nem is szeretnék egy olyan világban élni, ahol ez elvárás. Amit kaptam, az egy nyers leirat volt, meglepően kevés kapitális hibával (talán a kontextusban használt tulajdonnevek kivételével, ahol tényleg nem volt jó a ráta).

A fenti ábra alapján szemléltetett képfelismerés egy tipikus klasszifikáció példa, és egyébként a felügyelt tanulás (supervised learning) klasszikus esete. A hálót előre címkézett (azaz felügyelt módon) “macska/nem macska” képekkel tanítják be, ami után a háló önálló működésre képes – az, hogy mennyire teszi jól a dolgát, az a tanításhoz használt képek (általánosan, az angol terminológia szerint ún. training set) számosságától és minőségétől, a tanító algoritmustól és a háló egyéb paramétereitől függ. Ez tehát még nem generálás, legalábbis a klasszikus értelemben nem, ami, a kép kontextusban, inkább új képek létrehozása lenne. Generatív AI alkalmazásokhoz szükség van fundamentálisan új megoldásokra (amikről felületesen még szólni fogok), de ez az egyszerű architektúra is képes már generatív kimenetet létrehozni. Ehhez tegyük fel, hogy a neurális hálót hangfolyamokkal tanítjuk és a háló kimenete mindig a hangfolyam következő hangjegye. Azaz, az AI a hangfolyam egymás után következő hangjegyeit prediktálja, ami tekinthető egyfajta kategorizálásnak is, pl. ”az eddigi hangfolyam alapján a következő hangjegy az F”.

Zene szintézis mesterséges intelligenciával

Hangfolyamok AI-alapú feldolgozásához sokszor használnak ún. visszacsatolt neurális hálókat (recurrent neural nets, RNN), amik a fenti ábra egyszerű modelljét “memóriával” egészítik ki, azaz a hálónak van kontextusa arról, hogy milyen bemeneteket (hangjegyeket) látott korábban. Matematikailag ezt úgy lehet elérni, hogy neurális háló rétegei nem csak “balról jobbra”, hanem “visszafelé” is tudnak információt továbbítani.

Egy RNN önmagában alkalmas zene generálásra, de a modern alkalmazások komplexebb, ha úgy tetszik, moduláris architektúrákat alkalmaznak. Egy elterjedt kombináció RNN-ek és az ún. generatív ellenséges hálózatok (generative adversarial network, GAN) zene szintézisre való alkalmazása. A GAN-ok esetében már tényleg a legmodernebb (matematikai) technológiákról van szó; míg az RNN-ek története sok évtizedre nyúlik vissza, a GAN megjelenése 2014 körüli. Az alapgondolat a játékelméletből merít, és a lényege az, hogy két neurális háló “játszik” egymás ellen: a generátor, és az “ellenség”, a diszkriminátor. A játék abból áll, hogy a generátor teszteli a diszkriminátort, hogy az rájön-e, hogy a generátor “igaz” vagy “hamis” példákat mutat neki. Az igaz példák training set-ből származnak, a hamisak pedig a generátor által előállított kimenetek – képek, zenék vagy egyéb, a felhasználásnak megfelelő adat. A működésből az is látszik, hogy a GAN nem felügyelt (unsupervised) tanulás, mert az okosítás gyakorlatilag a diszkriminátor (és nem emberek által felcímkézett adatok) segítségével történik. A játéknak akkor van vége, amikor egyensúlyba kerül, pl. Nash-egyensúlyba (equilibrium), amit az egykor nagyot ment Egy csodálatos elme sajátos módon próbált szemléltetni. Ekkor a generátor jó eséllyel emberszerű (a példánk és kontextusunk szerint) zenék szintetizálására képes.

AI modulár

Az egyik mainstream piaci AI zene generátor, a Suno belsejében is egy RNN-GAN architektúra dolgozik, kiegészítve még más modulokkal is. Az egyik fontos felismerés, hogy egy ilyen architektúra nem szükségszerűség, azaz, más fajta kombóval is lehet zenét generálni – pl. GAN helyett ún. diffusion modellek segítségével (lsd. például ebben a Meta kutatói által publikált cikkben). A GAN koncept szerzője Ian Goodfellow[2], a modern AI kutatás egyik legmeghatározóbb szereplője, egy publikus hozzászólásában is arról beszél, hogy a GAN egy általános elv, ami nem zárja ki, hogy RNN-ekkel kombinálva használják (pl. a generátor és a diszkriminátor is lehet egy-egy RNN). Ebből a fenti megállapítás megfordítása is következik: a GAN-t nem csak zene (és/vagy kép) generálásra lehet használni.

Az látszik tehát, hogy AI technológiák terén egy arzenál áll rendelkezésre, ami ráadásul folyamatosan nőni és alakulni fog, és a felhasználókra van bízva, hogy milyen módon és kombinációban kerülnek alkalmazásra. A felhasználásnak, testreszabásnak és továbbfejlesztésnek számos rétege elképzelhető: a Suno, ChatGPT vagy épp AIrite felhasználóktól a programozókon, vagy ún. AI engineer-eken át (akik olyan környezetekkel tudnak új megoldásokat létrehozni mint pl. a Tensorflow vagy a WaveNet) az elméleti kutatókig (akik a mostanra tengermély AI szakirodalom számtalan területén tudnak innoválni).

Egy zenei analógiával élve vannak, akik szintiket vesznek és használnak, vannak, akik kisebb, “primitív” modulokból építenek (ún. modulár) hangszereket (a szakma jeles hazai képviselői pl. TELEϟPORT, Alpár vagy Triglav), és vannak olyanok is, akik maguk fejlesztenek új modulokat (megint csak itthonról pl. a DOBOZ termékei). Hasonló profilokat találhatunk a szoftveres világban is (az Ableton és társai körüli diverz felhasználói közösségek).

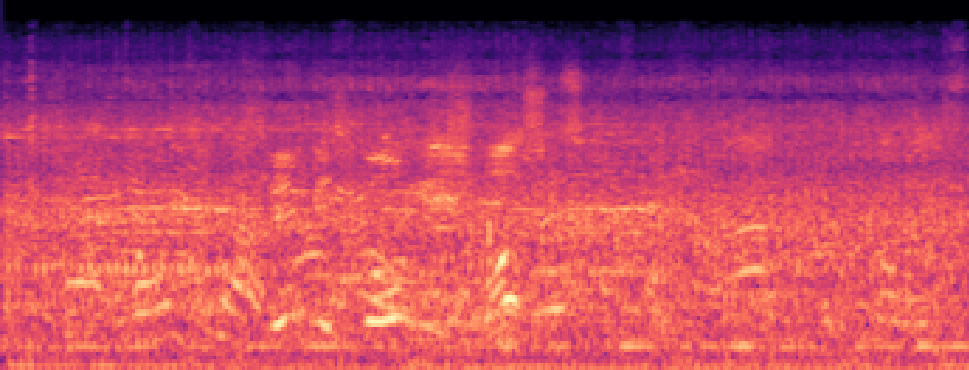

A nem túl meglepő felismerés tehát az, hogy az AI elterjedésével egyre több lesz mind a végfelhasználói (business-to-consumer, B2C), mind a közvetett (business-to-business, B2B) alkalmazás, a zenei és persze egyéb felhasználásokban is. Zenében egyelőre inkább csak B2C alkalmazások léteznek, pl. a text-to-music műfajban a már említett Suno mellett még az Udio egy hasonló szolgáltató, de már vannak alacsonyabb szintű szolgáltatások is, pl. a TensorFlow programozói könytárra alapuló leírások. Indirekt pedig olyan jelenségek, mint az AIrite is jelzik (létezik egy magyar nyelvű szövegek leírására szakosodott magyar cég), hogy testreszabott, nem triviális AI alkalmazások fejlesztése nem csak az egy kézen megszámolható multicégek kiváltsága. Nem generatív felhasználásokból biztosan több van (könnyebb feladatról lévén szó), például a Cyanite német startup terméke zeneszámok automatikus taggelését képes elvégezni (egyébként a hangfájl spektogram képe alapján, tehát képfelismerés segítségével).

Ha testreszabható AI architektúrák egy szélesebb producer közösség kezébe tudnak majd kerülni, akkor nem csak saját neurális háló konfigurációkon keresztül tudnak majd hatni arra, hogy milyen típusú zenéket generál az algoritmus, hanem a tanításhoz használt zenék összeállításán keresztül is. A saját vagy testreszabott traning set-ek összeállítása kemény dió (talán még keményebb, mint az AI algoritmusokban való jártasság kitanulása), mert a hatékony tanításhoz tipikusan sok és jó minőségű adatra (zenére) van szükség, ami zene esetében különösen nagy kihívás, tekintettel a szerzői jogokra is. A fent említett Suno és Udio cégeket az év elején amerikai lemezkiadók beperelték, mert a vád szerint a cégek engedély nélkül használták a kiadóknál lévő művészek zenéit az AI rendszereik tanítására. Reméljük, hogy a jövő generatív AI-ja transzparens, fair és legit lehet a tanításhoz használt adattal kapcsolatban, miközben versenyképes is maradhat a zene minőségét illetően.

Sok további technikai, morális, kulturális és filozófiai kérdés van még, például, hogy van-e egyáltalán szükség generatív zene AI-ra? Vagy hogy van-e, és ha igen, mi a különbség a klasszikus hangszerek, szintetizátorok (beleértve a MIDI-t, effekteket stb.), DAW-ok (Ableton és hasonlók) és a mesterség intelligenciával generált zenék megítélése között? Van-e érdemi különbség, ha valaki meglévő zenék és zenekultúra által inspirálódik (a klasszikus zenész fejlődése), és ha az AI-t tanítja ugyanez a zenei örökség? Nemrég megmutattam egy zenész barátomnak, hogy mit generált a Suno egy (általam) feldúdolt bemenet és egy rövid szöveg prompt alapján, ami, legalábbis technikailag, elég komoly eredmény volt, gondoltam. Őt nem nyűgözte le annyira az eredmény, de azt mondta, hogy midizéshez akár építene is ilyen kimenetre, azaz a hangfolyamot mint triggert használná a saját hangszeres setupjában.

Jelen cikk az EM GUIDE projekt keretein belül jött létre. Az EM GUIDE célkitűzése az európai független zenei magazinok támogatása, és underground zenei színterek erősítése. A projektről bővebben az emgui.de oldalon olvashattok.

Az Európai Unió finanszírozásával. Az itt szereplő vélemények és állítások a szerző(k) álláspontját tükrözik, és nem feltétlenül egyeznek meg az Európai Unió vagy az Európai Oktatási és Kulturális Végrehajtó Ügynökség (EACEA) hivatalos álláspontjával. Sem az Európai Unió, sem az EACEA nem vonható felelősségre miattuk.

Christian Cachin, Marko Vukolić, “Blockchain Consensus Protocols in the Wild”, 2017. https://arxiv.org/abs/1707.01873 ↩︎

Ian Goodfellow a Deep Learning könyv egyik szerzője is, amiről (viccesen) ő maga is azt mondja (egy Coursera interjúban Andrew Ng-vel), hogy talán többen olvassák/veszik a könyvet, mint aminek értelme lenne; amivel valószínűleg arra utal, hogy a hype sok embert megvezet, míg a könyv szigorú (matematikai) szakirodalom, tipikusan poszt-graduális oktatási környezetnek szánva. ↩︎